Geräusche erkennen und virtuell Gebäude bauen

emergenCITY Forschende tauschten sich auf interner DemoFair über aktuelle Erkenntnisse aus

emergenCITY Forschende tauschten sich auf interner DemoFair über aktuelle Erkenntnisse aus

Serious Games, Real-time Code Generation, Klassifikation von Umgebungsgeräuschen: Zur DemoFair am 24. Februar präsentierten emergenCITY-Wissenschaftler:innen einander einen aktuellen Zwischenstand ihrer Forschungsergebnisse. Zu verschiedensten Themen traten mehr als 50 Teilnehmende - von assoziierten Promovierenden über wissenschaftliche Mitarbeitende bis zu den PIs der drei beteiligten Universitäten – in den angeregten Austausch. Diese interne Vernetzung gab einen guten Überblick über die vielfältigen Entwicklungen, die bei emergenCTIY parallel fortschreiten.

Die Forschenden stellten bekannte Aushängeschilder der emergenCITY-Forschung wie den Rettungsroboter Scout, eine überarbeitete Version des Serious Games Krisopolis und den Nexus Demonstrator des Deutschen Zentrums für Luft- und Raumfahrt (DLR) in weiterentwickelter Form vor. An einem Modell der Litfaßsäule 4.0 erklärte der emergenCITY-Wissenschaftler Joachim Schulze den aktuellen Entwicklungsstand des ersten Prototyps der Säule. Den mit einem Warn- und Hinweisdisplay ausgestatteten Protoypen wird emergenCITY in Kooperation mit dem Werbevermarkter Ströer in Darmstadt aufstellen.

Auch die geplanten Sensorboxen für das Lichtenberg-Quartier führte das Team um Frank Hessel vor – mit einem neuen Sensor, der Umgebungsgeräusche klassifizieren kann. Diesen entwickelten Hicham Bellafkir und Markus Vogelbacher. Urban Sound Classification heißt das Programm, das mehr als 70 öffentliche Umgebungsgeräusche – von Hundebellen über Musik und Sirenen – erkennt und einordnet.

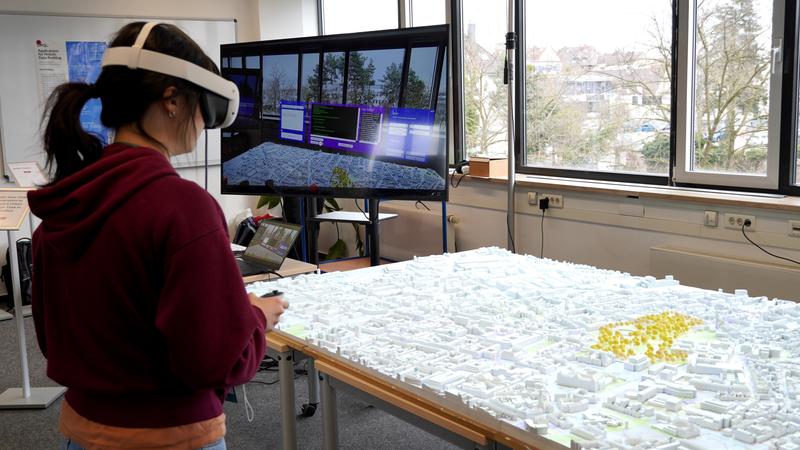

Auch weitere Integrationen neuer Einwicklungen in bisherige Demonstratoren ließen sich im Lab bei der DemoFair beobachten. Die Real-time Code Generation von Yanni Mei baut auf dem emergenCITY-Stadtmodell von Darmstadt auf. In einer Augmented Reality (AR) Version des Modells entwickelt die Forscherin eine Software, über die Stadtplaner:innen bestehende Gebäude in Darmstadt lokalisieren und neue virtuell gestalten können. Die Auswirkungen beispielsweise auf den Verkehrsfluss können Benutzende dann direkt live auf der Animation des Stadtmodells City MoViE beobachten.

Per Spracheingabe und mithilfe Künstlicher Intelligenz hat Yanni Mei ein Programm entwickelt, das einen sprachlichen Befehl in der erweiterten Realität direkt in einen ChatGPT-Prompt umwandelt, der schließlich den entsprechenden Code generiert. Wenn man sagt: „Lokalisiere das Krankenhaus!“, dann erscheint nach wenigen Sekunden bereits ein roter Kreis um das Darmstädter Krankenhaus im virtuellen Stadtmodell. So soll es auch Stadtplaner:innen ohne tiefergehende Programmierkenntnisse ermöglicht werden, in der erweiterten Realitätsumgebung des Modells gestalterisch tätig zu werden.